Aspirer un site web

Aspirer un site web

Wget peut suivre les liens des pages HTML et XHTML et créer une copie locale de sites web distants, en récréant complètement la structure du site original. Ceci est parfois désigné sous le nom de « téléchargement récursif ». Wget peut aussi convertir les liens dans les fichiers HTML téléchargés pour la consultation locale.

L’url : http://www.linux-france.org/ est un exemple

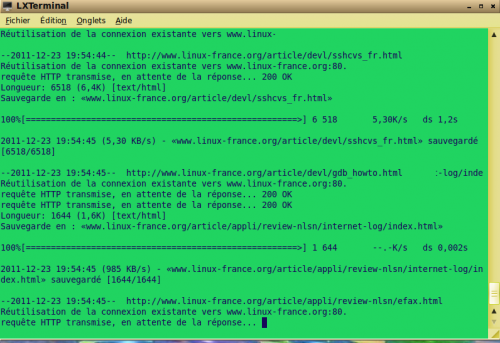

Lancer la commande ci-dessous dans un terminal.

wget -r -k -np -T 10 -t 1 http://www.linux-france.org/

-r

Active le téléchargement récursif. (les liens de la page sont aussi téléchargés)

-k

Une fois que le téléchargement est terminé, convertit les liens du document pour qu'il soit consultable en local. Ceci affecte non seulement les liens hypertextes, mais aussi toute partie du document qui lie un contenu extérieur, comme les images, les liens vers les feuilles de style, les hyperliens vers du contenu non-HTML, etc.

Chaque lien sera modifié de l'une des deux façons suivantes :

Les liens vers les fichiers qui ont été téléchargés par wget seront transformés en liens relatifs.

Exemple : si le fichier téléchargé /toto/doc.html a un lien vers /titi/image.gif, aussi téléchargé, alors le lien dans doc.html sera modifié pour pointer vers ../titi/image.gif. Ce type de transformation fonctionne très bien quelle que soit la combinaison de répertoires.

Les liens vers les fichiers qui n'ont pas été téléchargés par Wget seront modifiés pour inclure le nom d'hôte et le chemin absolu vers la destination.

Exemple : si le fichier téléchargé /toto/doc.html a un lien vers /titi/image.gif (ou vers ../titi/image.gif), alors le lien dans doc.html sera modifié pour pointé vers http://nom-d-hote/titi/image.gif.

Grâce à ceci, la navigation locale fonctionne bien : si un fichier lié a été téléchargé, le lien désigne son nom local ; sinon, le lien désigne son nom Internet complet plutôt qu'un lien brisé. Le fait que les anciens liens soient convertis en liens relatifs vous permet de déplacer ailleurs les hiérarchies téléchargées.

Remarquez que Wget ne peut pas savoir avant la fin du téléchargement quels seront les liens téléchargés. C'est pourquoi le travail accompli par -k n'a lieu qu'après la fin de tous les téléchargements.

-np

Empêche de remonter dans le répertoire parent.C'est une option utile, puisqu'elle garantit que seuls les fichiers en dessous d'une certaine hiérarchie seront téléchargés.

-T 10

Positionne le décompte de lecture à secondes. En cas d'émission d'une lecture réseau, le descripteur de fichier est vérifié pour un décompte, sinon une connexion pendante (lecture non interrompue) pourrait subsister. Le décompte par défaut est 900 secondes (quinze minutes). Positionnez le décompte à 0 pour désactiver la vérification des décomptes.

Le temps max est positionné à secondes pour aspirer un lien. Quand cette option est omise, un lien difficilement accessible peut ralentir considérablement l'aspiration du site.

-t 1

Définit le nombre de tentatives à 1. Spécifiez 0 ou inf pour un nombre illimité de tentatives. Par défaut 20 tentatives sont effectuées, à moins qu'une erreur fatale telle que « connexion refusée » ou « non trouvé » (404) apparaisse.

Ici, on veut qu'il n'y ait qu'une seule tentative de connexion afin d'accélérer le traitement d'aspiration.

Il va alors télécharger toutes les pages du site, et créer un dossier portant le nom du site dans votre répertoire courant, contenant toutes les pages web.